Startuplar, bireyci ve kapitalist dürtülere dayalı yapay zekâ sistemlerini ithal edip dayatıyor

Haziran ayında Fas’ın Tanca kentinde düzenlenen ikinci CyFyAfrica 2019 (Teknoloji, İnovasyon ve Toplum Konferansı), çoğunluğu Afrika ve Asya’dan olmak üzere 65’ten fazla ülkeden gelen politika yapıcılar, BM delegeleri, bakanlar, devlet yetkilileri, diplomatlar, gazeteciler, teknoloji şirketi temsilcileri ve akademisyenlerin katılımıyla canlı, çeşitli ve dinamik bir konferans oldu. Konferansın temel amacı, açıkça belirtildiği üzere, Afrika’nın sesini küresel söylemde daha görünür kılmaktı. Ortak ev sahiplerinden Gözlemci Araştırma Vakfı’nın başkanı açılış konuşmasında, Afrika’nın toplumsal, eğitim, sağlık, ekonomi ve finans alanlarındaki sorunlarını çözmek için teknolojiye giderek daha fazla yöneldiğine dikkate çekerek, bu nedenle özellikle Afrika gençliğinin sesinin öne çıkarılması gerektiğini vurguladı. Konferans, gençlere bir platform sağlamayı amaçlıyor; bu da, farklı üniversitelerden Batılı akademisyenlerin yanı sıra sanayi ve ticaret alanlarından teknoloji geliştiricilerle bir araya gelme fırsatıyla destekleniyordu.

Silikon Vadisi’nin teknoloji girişimlerine Afrika’da birçok karşılık bulmak mümkün; Addis Ababa’daki “Sheba Vadisi”, Lagos’taki “Yabacon Vadisi” ve Nairobi’deki “Silikon Savanası” bunlardan sadece birkaçı. Bu merkezler bankacılık, finans, sağlık hizmetleri ve eğitim gibi sektörlerde “en son yenilikleri” takip ediyor. Kıta, bu çeşitlenen teknolojik ve yapay zekâ gelişmelerinden önemli ölçüde yararlanabilir: Örneğin, Etiyopyalı çiftçiler kitle kaynaklı verileri kullanarak daha isabetli tahminler yapabilir ve daha verimli mahsuller elde edebilir. Dünya Sağlık Örgütü’nün ilgili bülteninde de belirtildiği gibi, veriler sağlık ve alanlarındaki hizmetlerin iyileştirilmesine katkı sağlayabilir. Aynı zamanda veriler, toplumsal, siyasi ve ekonomik alanlardaki derin eşitsizlikler arasında köprü kurmaya yardımcı olabilir. Örneğin, karar alma pozisyonlarındaki yaygın cinsiyet eşitsizliklerini görünür kılarak bu sorunların gündeme taşınmasına yardımcı olabilir ve dahası toplumsal ve yapısal reformları destekleyebilir.

Gelgelelim bu yazıda tartışmak istediğim konu bu değil. Hem Afrika kıtasında hem de dışında, “yapay zekâ”, “akıllı” veya “veri odaklı” her şeyi sorgulamadan ve olası olumsuz sonuçlarını bir an bile düşünmeden körü körüne benimsemekten mutluluk duyan sayısız teknoloji hayranı var. Teknolojik yeniliklerden söz edildiğinde, teknoloji savunucularının çoğu zaman, hayatın her alanını ne olursa olsun dijitalleştirme çabalarına gerekçeler sunduğunu görüyoruz. CyFyAfrica 2019 katılımcılarının çoğunun öne sürdüğü fikirler ne kadar anlamlı olursa olsun, Afrika’da (ve başka yerlerde) etik açıdan sorunlu veya tehlikeli girişim ve uygulamaları “yenilikçi”, “ezber bozan” veya “oyun değiştirici” olarak sorgusuz sualsiz benimseyen teknoloji fanatiklerinden zaten bolca mevcut. Kıtada düzenlenen büyük ölçekli yapay zekâ veya makine öğrenmesi konferanslarının konuşmacı listelerine veya tartışma başlıklarına göz atmaya bile gerek yok: Bu etkinliklerde etik meseleler, veri gizliliği veya yapay zekânın yol açabileceği olumsuz etkiler neredeyse hiç yer bulmuyor. Nairobi’de düzenlenecek olan Deep Learning Indaba konferansı bunun tipik örneklerinden biri.

Afrika’nın teknolojik geleceğini şekillendiren yeterince teknolojiye tapan insan zaten varken, dünyanın diğer bölgelerinden çıkarılabilecek derslere ve alınması gereken önlemlere dikkat çekmek büyük önem taşıyor. Afrika’nın, dijitalleşmenin ve yaşamın her alanına teknolojinin nüfuz etmesinin karanlık yüzünü görmek için kendi felaketlerini yaşamasına gerek yok.

Veri ve yapay zekâ, karmaşık toplumsal sorunlara hızlı çözümler sunuyor gibi görünüyor. Asıl sorun da tam olarak burada başlıyor. Dünyanın dört bir yanında yapay zekâ teknolojileri sigorta, mobil bankacılık, sağlık ve eğitim gibi alanlardaki karar alma süreçlerine giderek daha fazla entegre ediliyor. Afrika’nın dört bir yanında da, Nijerya’da Printivo, Kenya’da Mydawa gibi çeşitli girişimler, bir sonraki “en ileri” uygulamayı, aracı veya sistemi geliştirme hedefiyle ortaya çıkıyor. Bu girişimler, “kullanıcıların” davranışlarını ve alışkanlıklarını analiz etmek, anlamak ve karar üretmek için mümkün olduğunca çok veri topluyorlar.

Ancak en yeni işe alım uygulamasını veya son teknoloji mobil bankacılık sistemini geliştirme yarışında, startuplar ve şirketler her veri noktasının ardındaki insanı göz ardı ediyor: “Veri”, bireyleri tamamen silerek, tartışmasız bir şekilde teknoloji şirketlerinin ve hükümetlerin mülkü gibi ele alınıyor. Bu yaklaşım, insan davranışlarını “manipüle etmeyi” ya da onları “dürtmeyi” kolaylaştırıyor — üstelik sonuçlar genellikle bireyler için değil, şirketler için kârlı oluyor. “Dürtme” mekanizmaları, ister beslenme alışkanlıkları ister egzersiz rutinleri olsun, bireylerin davranışlarını “düzeltmek” için norm haline geldikçe, otomatik sistemleri geliştiren özel sektör mühendislerine neyin “doğru” olduğuna karar verme yetkisi veriliyor. Bu sırada, örneğin “fit bir vücut” ya da “sağlıklı beslenme alışkanlıkları” gibi kalıplaşmış imgelere uymayan bireyler cezalandırılıyor ve sistemin daha da dışına itiliyor. Bireyin hakları, bu sistemlerin uzun vadeli toplumsal etkileri ve en savunmasız gruplar üzerindeki kasıtlı veya kasıtsız sonuçları ise çoğu zaman dikkate alınmıyor — tabii bu kişiler tartışmaya katılma şansı bulabilirlerse.

Tıpkı büyük veri gibi, yapay zekâ da çoğu zaman gelişigüzel kullanılan bir terim. Ne anlama geldiği farklı disiplinler arasında tartışmalı ve bu terimi net biçimde tanımlamak neredeyse imkansız. Yapay zekâ denince, aşırı abartılmış ve yanıltıcı robotlardan, Facebook’un Haber Akışınızda ne göreceğinizi belirleyen makine öğrenmesi algoritmalarına, hatta “akıllı” buzdolabınıza kadar her şey kast edilebiliyor. Bu alanın araştırmacıları da, medya mensupları da zaman zaman yapay zekânın yeteneklerini abartarak ona adeta tanrısal bir güç atfediyor. Oysa Melanie Mitchell gibi önde gelen yapay zekâ akademisyenlerinin de vurguladığı gibi, insanüstü bir “süper zeka”ya ulaşmamıza çok var. Benzer biçimde Jeff Bigham da, çokça tartışılan “otonom” sistemlerin – ister robotlar ister konuşma tanıma algoritmaları olsun – büyük kısmının perde arkasında, çoğu zaman düşük ücretlerle çalışan insanların emeğine dayandığını belirtiyor.

Yapay zekâ sistemlerinin yeteneklerinin abartılması, dikkatleri “katil robotlar” gibi abartılı tehlikelerden çok daha görünmez, karmaşık ve yavaş ilerleyen gerçek tehlikelerden uzaklaştırıyor. Yapay zekâ araçları genellikle nesnel ve değerden bağımsız olarak sunuluyor. Doğrusu, birçok otomatik sistem, örneğin işe alma ve polislik için kullanılanlar, insan yanlılığını ortadan kaldırdığı iddiasıyla öne sürülüyor. Ne de olsa, otomatik sistemler herkes için aynı kuralları uygular. Ancak bu, otomatik sistemlerle ilgili en yaygın ve zararlı yanılgılardan biridir. Harvardlı matematikçi Cathy O’Neil’in Matematiksel İmha Silahları adlı kitabında açıkladığı gibi, “algoritmalar koda gömülü fikirlerdir”. “Yapay zekâ” ve “veri güdümlü” kavramları altında sunulan bu sistemler, siyasi olarak tarafsız gibi gözükse de, verilerin nasıl toplandığı, yorumlandığı ve (verileri kontrol eden ve analiz edenlerle uyumlu) belirli sonuçlar üretmek için nasıl kullanıldığı doğası gereği siyasi bir özellik taşır. Bu da, bu sistemlerin toplumsal yapıyı değiştirmesine, toplumsal kalıp yargıları pekiştirmesine ve zaten toplumsal hiyerarşinin en altında olan en savunmasız grupları daha da dezavantajlı hale getirmesine neden olur.

Yapay zekâ bizim yarattığımız, kontrol ettiğimiz ve sorumlu olduğumuz bir araçtır; tıpkı diğer tüm araçlar gibi tutarsızlıklarımızı, sınırlamalarımızı, yanlılıklarımızı ve siyasi ve duygusal arzularımızı bünyesinde barındırır ve yansıtır. Dünyayı nasıl gördüğümüz ve onu nasıl temsil etmeyi seçtiğimiz, inşa ettiğimiz algoritmik modellerin içine yansır. Bu yüzden, sistemleri kimlerin kurduğu ve hangi veri türlerini ve kaynaklarını kimin seçtiği, bu sistemlerin sahip olacağı etkiyi derinden etkileyecektir. Yapay zekâ sistemlerinin ürettiği sonuçlar, nesnel gerçeklerden ziyade, var olan toplumsal ve kültürel kalıp yargıları yansıtmaktadır.

Teknolojinin toplumsal alandaki kullanımı, ister bir sonraki suçlu kim olacak, isterse kimin ipoteğini ödeyemeyeceği gibi tahminlerle ilgili olsun, kasıtlı veya kazara, genellikle cezalandırıcı uygulamalara odaklanmaktadır. İnsanların suç işleme nedenleri veya cezaevinden çıkanların rehabilitasyonu ve desteklenmesi için neler yapılabileceği gibi yapıcı ve rehabilite edici sorular neredeyse hiç gündeme gelmemektedir. “Güvenlik” ve “düzen” sağlamak amacıyla geliştirilen ve uygulamaya konan teknolojik gelişmeler genellikle insanları rehabilite etmek yerine cezalandırmayı hedeflemektedir. Dahası, bu tür teknolojiler çoğu zaman bazı gruplara yönelik zalimce, ayrımcı ve insanlık dışı uygulamalara yol açmaktadır. Çin’de Uygurlara yapılan zulüm ve yoksulların haksız yere dezavantajlı duruma düşürülmesi bunun örneklerindendir. Benzer şekilde, Johannesburg ve Kampala gibi şehirlerde yüz tanıma teknolojisinin kullanılmaya başlanmasıyla, azınlık gruplarına karşı haksız ayrımcılık ve orantısız polislik faaliyetleri kaçınılmaz olacaktır.

Açıkça kabul edilsin veya edilmesin, yapay zekâ geliştiren ticari şirketlerin temel amacı genel olarak yanlılıkları düzeltmek değil, sanki insanlar sadece manipüle edilecek nesnelermiş gibi, bireysel “kullanıcıların” zayıflıklarını ve eksikliklerini ortaya çıkarmaktır. Bu şirketler, elde edebiliyorlarsa, bu tür “verilerin” otomatik olarak kendilerine ait olduğunu kabul etmektedirler. Afrika’nın teknoloji dünyasında yaygın bir dil haline gelen “veri madenciliği” ve “veri zengini kıta” etrafındaki söylemler, her bir veri noktasının ardındaki bireyin kendi bakış açılarından ne kadar da uzak olduğunu gözler önüne seriyor.

Veri için insan “madenciliği” söylemi, insanları alınmaya hazır hammaddeler olarak gören sömürgeci bir tavrı çağrıştırmaktadır. Toplumsal meselelere ilişkin karar alma süreçlerini kâr odaklı şirketler tarafından geliştirilen otomatik sistemlere devrettiğimizde, yalnızca toplumsal kaygılarımızın kurumsal teşviklerle (kâr) belirlenmesine izin vermekle kalmıyor, aynı zamanda karmaşık ahlaki soruları da şirketler dünyasına devretmiş oluyoruz.

Davranış temelli “kişiselleştirme” (diğer bir deyişle, Shoshana Zuboff’un Gözetim Kapitalizmi Çağı adlı kitabında ayrıntılarıyla ele aldığı gibi, insan deneyiminin kapitalist amaçlarla ayıklanması, basitleştirilmesi ve araçsallaştırılması) bazen yapay zekâ ile ilişkilendirilen bilim kurgu tehditleriyle karşılaştırıldığında sıradan görünebilir. Ancak bu, insanların özerkliklerinin ellerinden alındığı ve yalnızca işlenmek üzere ham veri olarak muamele gördüklerinin temelidir. Algoritmik davranış modellerinin yaptığı çıkarımlar, dünyanın tarafsız bir yansıması değildir ve derinlemesine nedensel açıklamalar sunmaz. Bunun yerine güçlü bir şekilde mevcut toplumsal ve tarihi adaletsizlikleri yeniden üretmektedir.

Teknoloji, genel olarak hiçbir zaman tarafsız veya nesnel değildir; toplumsal yanlılıkları, adaletsizliği ve haksızlığı yansıtan bir aynadır. Örneğin, konferans sırasında bir BM delegesi, çevrimiçi terörle mücadele için geliştirilen ancak hayal kırıklığı yaratacak şekilde açıkça İslami gruplara odaklanan ve çevrimiçi terörizmin gerçekçi olmayan, zararlı bir imajını çizen çalışmalara değindi: Son dokuz yılda Avrupa, Avustralya ve Kuzey Amerika’da 350 beyaz aşırılıkçı terör saldırısı gerçekleşti; ABD’de ise bu süre zarfında meydana gelen tüm saldırıların üçte biri beyaz aşırılıkçılıktan kaynaklanıyor. Bu durum, basmakalıp görüşlerin neyin sorun olarak algılandığını ve buna cevaben geliştirdiğimiz teknoloji türlerini nasıl şekillendirdiğini gösteren endişe verici bir noktayı ortaya koymaktadır. Sonrasında ise teknolojinin aynasından bulduklarımızı, yanlı sezgilerimizin kanıtı olarak benimseyip, kalıp yargıları daha da pekiştiriyoruz.

Teknolojideki bazı önemli küresel oyuncular (örneğin, endüstri sektöründen Microsoft ve Google’ın DeepMind‘ı1çn. Google DeepMind etik kuruluna ilişkin çeşitli tartışmalar oldu; akademik alandan Harvard ve MIT2çn. Ethics and Governance of Artificial Intelligence grubu Ocak 2017’den Haziran 2020‘ye kadar aktfiti) yapay zekânın toplum üzerindeki olası yıkıcı sonuçlarını kabul ederek etik kurulları ve etik müfredatlarını geliştirmeye başladılar3çn. Son yıllarda etik konusuna olan ilgi hem dünyadaki sağcı yönelim hem de şirketlerin etik değerleri kullanıyormuş gibi bile gözükme ihtiyaçlarının kalmaması ve büyük dil modellerini hızlı bir şekilde yayma ihtiyaçları nedeniyle oldukça azalmış durumda. Adil ve etik yapay zekâyı sürdürmek için çeşitli paydaşlar tarafından farklı yaklaşımlar ve perspektifler geliştirilmiştir ve bu çeşitlilik bir zayıflık değil, bir güçtür: Yapay zekânın farklı bağlamlarda ve kültürlerde ortaya çıkardığı çeşitli etik, toplumsal ve ekonomik sorunları ele almak için bir dizi çözüm üretmek için gereklidir. Ancak çoğu zaman, en son “etik çerçeve” veya “etik yapay zekâ için en iyi kılavuz” taslağını hazırlama girişimleri, statükoyu standart olarak merkeze almakta ve ortaya konan çözümün tek gerekli çözüm olduğunu ima etmektedir. Konferansın akademik konuşmacılarından birinin önerdiği gibi, yapay zekâ için herkese uyan tek bir etik çerçevede ısrar etmek, sadece ulaşılamaz olmakla kalmaz, aynı zamanda öngörülemeyen bağlamlarda ele alınması gereken sorunları daha da kötüleştirir.

Toplumun en kırılgan kesimleri, çeşitli hizmetlerin dijitalleşmesinden orantısız bir şekilde etkilenmektedir. Yine de yapay zekâya uygulanan etik ilkelerin çoğu katı bir şekilde faydacı olup, önemsedikleri şey “en çok sayıda insan için en büyük mutluluktur”; bu da tanımı gereği azınlıkları merkeze alan çözümlerin asla aranmaması anlamına gelir. Algoritmik karar alma süreçlerindeki adaletsizlik ve ayrımcılık gündeme geldiğinde, örneğin kadınların teknoloji endüstrisine girmekten sistematik olarak dışlandığı, azınlıklara insanlık dışı muamele uygulandığı ve sistematik yanlılıkların öngörücü polislik sistemlerine yerleştirildiği keşfedildiğinde, aranan “çözümler” orantısız bir şekilde etkilenen ötekileri neredeyse hiç merkeze almamaktadır: Şirket ve akademik etik kurulları tarafından geliştirilen hafifletici öneriler çoğunlukla etkilenen insanlara danışılmadan, onların katılımı sağlanmadan ortaya çıkmaktadır. Ancak, herhangi bir teknolojinin tasarlanması, geliştirilmesi ve uygulanması, ayrıca politika oluşturma süreçlerinde de her adımda bu grupların sesine öncelik verilmelidir. Bu, (en azından Batı’nın Silikon Vadisi söz konusu olduğunda) herhangi bir karmaşık toplumsal soruna tek taraflı olarak “teknik bir çözüm” getirmeye çalışan “herşeyi bilen” mühendislerin, toplumun savunmasız gruplarına gerçekten danışması ve onları sürece dahil etmesi gerektirmektedir.

Afrika, en son teknolojik gelişmeleri yakalamaya çalışırken, teknolojinin yol açabileceği zararlardan kıtanın en savunmasız insanlarını da korumalıdır. CyFyAfrica konferansının liderlerinin vurgulamak istediği gençlerin hakları, özgürlükleri ve mahremiyetlerinin korunmasına ve bunlara saygı gösterilmesine öncelik verilmelidir. Bu, ancak yerel değerleri, bağlamları ve yaşam biçimlerini dikkate alan bir şekilde, bireysel hak ve özgürlüklere yönelik kılavuz ilkeler ve güvence sağlanarak ve teknoloji anlatısının önemli bir parçası olarak eleştirel seslerin dahil edilmesiyle mümkün olabilir. Adil olmak gerekirse, CyFyAfrica bazı panellerde kimi eleştirel seslere yer verdi. Ancak, bu az sayıdaki eleştirel ses, ezici çoğunluk olan teknoloji meraklılarının sesinde kayboldu.

Konferansın ardından, Gözlemci Araştırma Vakfı tarafından yürütülen yarı akademik bir dergide, konşmacılara görüşlerini ve araştırmalarını yayınlama fırsatı verildi. Konferanstaki diğer konuşmacılar gibi ben de gözlemlerimi ve düşüncelerimi sunmaya teşvik edildim. Ancak, bu makalenin gönderdiğim bir versiyonu yayın kurulu tarafından çok eleştirel bulundu ve bu nedenle yayınlanması uygun görülmedi. İronik bir şekilde, Afrika’nın gençlerine ses verdiğini iddia eden platform, bunu ancak bu ses güçlü teknoloji şirketlerinin, politika yapıcılarının ve hükümetlerin anlatıları ve güdüleriyle uyumlu olduğunda yapıyor.

Afrika’nın teknolojikleşmesi ve dijitalleşmesi meselesi, nasıl bir toplumda yaşamak istediğimizle ilgili bir meseledir. Afrikalı gençlerin kendi sorunlarını çözmesi, neyi büyütmek ve dünyanın geri kalanına göstermek istediğimize karar vermemiz anlamına geliyor. Bu aynı zamanda, temel amacın ne olduğunu, kimin yarar sağlayacağını ve bu tür araçların uygulanmasından kimin dezavantajlı olabileceğini sorgulamadan en son teknoloji makine öğrenmesi sistemlerini veya diğer yapay zekâ araçlarını ithal etmemek anlamına gelir.

Dahası, Afrikalı gençlerin yapay zekâ alanına öncülük etmesi, bireyci ve kapitalist dürtüler üzerine kurulu Batılı yapay zekâ sistemlerini körü körüne ithal etmek yerine, çeşitli yerel topluluklara hizmet eden programlar ve veri tabanları oluşturmak anlamına gelmektedir. Bu aynı zamanda kendi geliştirdiğimiz sistemleri incelemek ve Batılı perspektifleri standart olarak kabul etmek yerine belirli amaçlara hizmet eden etik standartlar belirlemek anlamına da gelmektedir. Anlatının çoğunun göç, kuraklık ve yoksulluk gibi olumsuz imgelerle engellendiği bir kıtada, sorunlarımızı kendimiz çözmek için yapay zekâyı kullanmak demek, yapay zekâyı istediğimiz şekilde, kim olduğumuzu ve nasıl anlaşılmak ve algılanmak istediğimizi anlamak için kullanmak demektir, yani toplumsal değerlerin zafer kazandığı ve kimsenin geride bırakılmadığı bir kıta.

Abeba Birhane, University College Dublin’de Bilişsel Bilimler alanında doktora adayıdır. Bedenlenmiş biliş, dijital teknoloji çalışmaları ve eleştirel veri bilimi arasında kesişen disiplinlerarası araştırması, bireyler, toplum ve dijital teknolojiler arasındaki dinamik ve karşılıklı ilişkileri araştırıyor. Aeon Dergisine katkıda bulunuyor ve biliş, yapay zekâ, etik ve veri bilimi hakkında düzenli olarak blog tutuyor.

Kaynak: Real Life Magazine, 18 Temmuz 2019

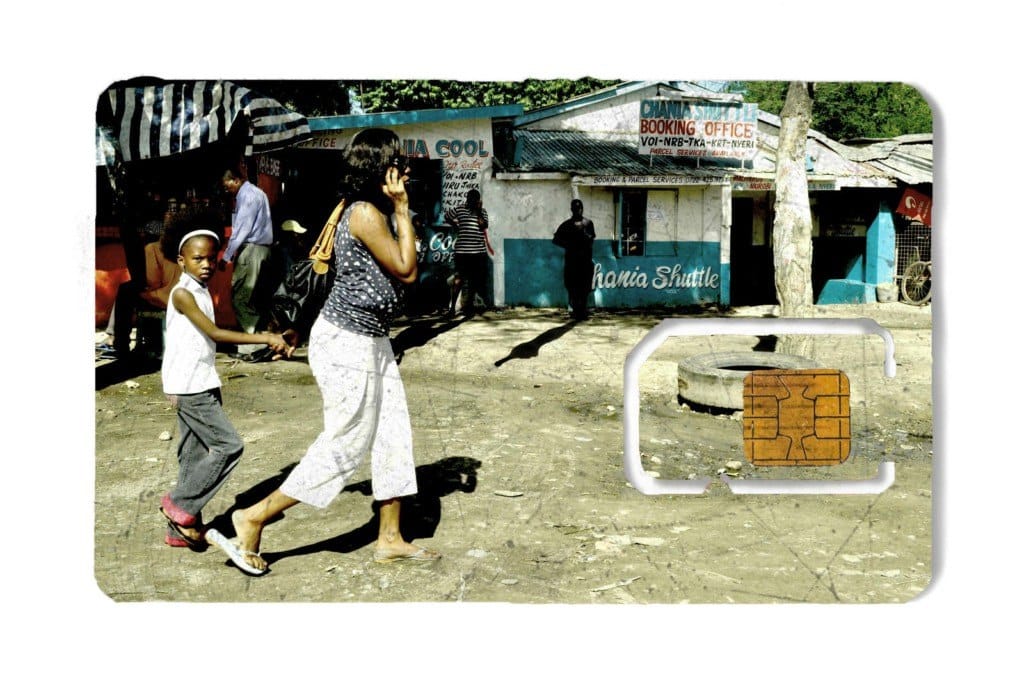

Resim: Isaac Kariuki’nin SIM Kart Projesinden. Sanatçının izniyle.