Yeni bulgular, veri kaynaklarının gücü nasıl da en güçlü teknoloji şirketlerinin elinde yoğunlaştırdığını gösteriyor.1

Yapay zekâ tamamen veriyle ilgilidir. Algoritmaları istediklerimizi yapmaları amacıyla eğitmek için yığınlarca ama yığınlarca veriye ihtiyaç var ve yapay zekâ modellerine giren veri neyin ortaya çıkacağını da belirliyor. Ancak sorun şu: Yapay zekâ geliştiricileri ve araştırmacıları, kullandıkları verilerin kaynakları hakkında pek bir şey bilmiyorlar. Yapay zekânın veri toplama uygulamaları, yapay zekâ modeli geliştirme karmaşıklığına kıyasla yeterince olgunlaşmamıştır. Devasa veri kümeleri genellikle içlerinde ne olduğu ve nereden geldikleri hakkındaki net bilgiyi içermez.

Hem akademiden hem de endüstriden 50’den fazla araştırmacıdan oluşan bir grup olan Veri Kökeni Girişimi2 bunu düzeltmek istedi. Çok basit bir şekilde şunu öğrenmeyi amaçladılar: Yapay zekâyı oluşturmak için kullanılan veriler nereden geliyor? 600’den fazla dili, 67 ülkeyi ve otuz yılı kapsayan yaklaşık 4.000 kamuya açık veri kümesini denetlediler. Veriler 800 benzersiz kaynaktan ve yaklaşık 700 kuruluştan geliyordu.

MIT Technology Review ile özellikle paylaşılan bulgular endişe verici bir eğilime işaret ediyor: Yapay zekânın veri uygulamaları, ezici bir şekilde birkaç baskın teknoloji şirketinin elinde gücü yoğunlaştırma riski taşıyor.

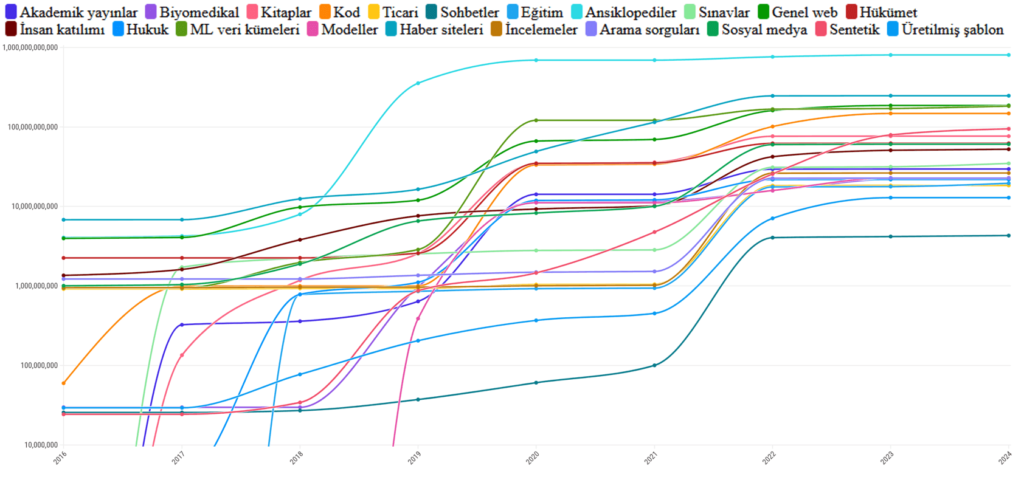

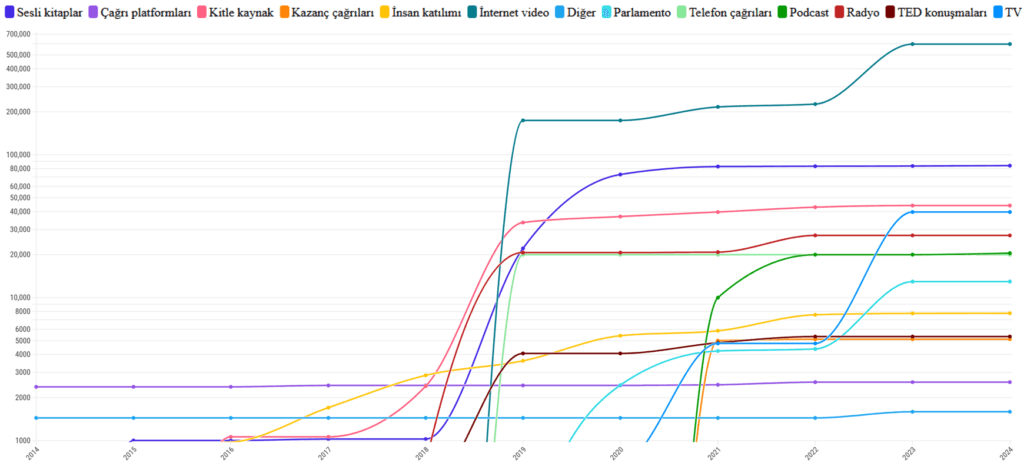

Projenin bir parçası olan MIT araştırmacısı Shayne Longpre, 2010’ların başında veri kümelerinin çeşitli kaynaklardan geldiğini söylüyor.

Metin tabanlı modellerde web, sosyal medya ve sentetik verilerin artan kullanımı

Kaynak: Veri Kökeni Girişimi, Etkileşimli grafik: https://flo.uri.sh/visualisation/20565805/embed

Sadece ansiklopedilerden ve web’den değil, parlamento tutanakları, kazanç çağrıları ve hava durumu raporları gibi kaynaklardan da geliyordu. Longpre, o zamanlar yapay zekâ veri kümelerinin bireysel görevlere uyacak şekilde özel olarak derlenip düzenlendiğini ve farklı kaynaklardan toplandığını söylüyor.

Ardından, 2017 yılında dil modellerinin temelini oluşturan mimari olan dönüştürücüler3 icat edildi ve yapay zekâ sektörü, modeller ve veri kümeleri büyüdükçe performansın iyileştiğini görmeye başladı. Günümüzde çoğu yapay zekâ veri kümesi, İnternetteki materyallerde gelişigüzel gezilerek oluşturulmaktadır. 2018’den bu yana ses, görüntü ve video gibi tüm ortamlar için kullanılan veri kümeleri için baskın kaynak web olmuştur ve oradan kazınmış veriler ile iyi bir şekilde derlenip düzenlenmiş veri kümeleri arasında bir boşluk ortaya çıkmış ve genişlemiştir.

Konuşma tabanlı modellerde web, sosyal medya ve sentetik verilerin artan kullanımı

Kaynak: Veri Kökeni Girişimi, Etkileşimli grafik: https://flo.uri.sh/visualisation/20546843/embed

Longpre, “Temel model geliştirmede, yetenekler için, verilerin ve web’in ölçeği ve heterojenliğinden daha önemli bir şey yok gibi görünüyor” diyor. Ölçek ihtiyacı, sentetik verilerin4 büyük ölçüde kullanımını da artırdı.

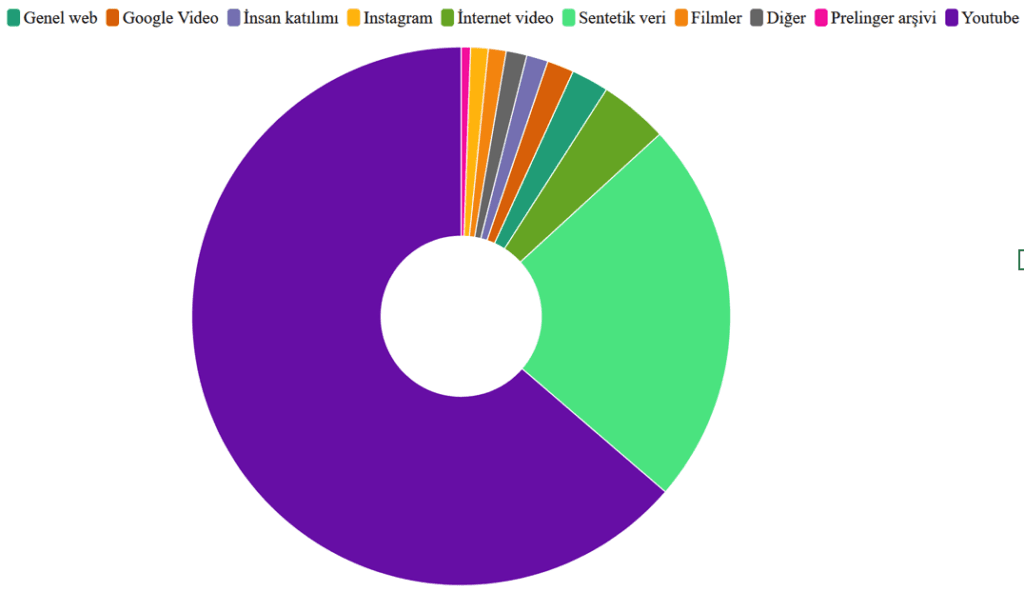

Geçtiğimiz birkaç yıl, video ve görüntü üretebilen çok kipli üretken yapay zekâ modellerinin de yükselişini gördü. Büyük dil modelleri gibi, mümkün olduğunca çok veriye ihtiyaçları var ve bunun için en iyi kaynak YouTube oldu.

Video modelleri için, grafikte görebileceğiniz gibi, hem konuşma hem de görüntü veri kümeleri için verilerin %70’inden fazlası tek bir kaynaktan geliyor.

Video tabanlı modellerin veri kaynakları

Kaynak: Veri Kökeni Girişimi, Etkileşimli grafik: https://flo.uri.sh/visualisation/20688869/embed

Bu, Google’nin ana şirketi, YouTube’nin sahibi Alphabet için bir nimet olabilir. Metin web boyunca dağıtılırken ve birçok farklı web sitesi ve platform tarafından kontrol edilirken, video verileri tek bir platformda aşırı yoğunlaşmıştır.

Longpre, “Web’deki en önemli verilerin çoğu üzerinde tek bir şirkete büyük bir güç yoğunluğu sağlıyor” diyor.

AI Now Enstitüsü‘nün eş genel müdürü Sarah Myers West, Google kendi yapay zekâ modellerini de geliştirdiği için, şirketin bu büyük avantajının bu verileri rakipler için nasıl kullanıma sunacağına dair soruları da gündeme getirdiğini söylüyor.

Myers West, “Verileri doğal olarak oluşan bir kaynakmış gibi değil de, belirli süreçlerle oluşturulmuş bir şey gibi düşünmek önemlidir” diyor.

“Eğer etkileşimde bulunduğumuz yapay zekânın çoğunun veri kümeleri; büyük, kâr amacı güden şirketlerin niyetlerini ve tasarımını yansıtıyorsa, bu durum dünyamızın altyapılarını bu büyük şirketlerin çıkarlarını yansıtacak şekilde yeniden şekillendirecektir” diyor.

Veri Kökeni Girişiminde de yer alan ve Teknoloji şirketi Cohere’de araştırma başkan yardımcısı olan Sara Hooker, bu monokültür, veri kümesinde insan deneyiminin ne kadar doğru tasvir edildiği ve ne tür modeller oluşturduğumuz hakkında soruları da beraberinde getiriyor diyor.

İnsanlar belirli bir kitleyi göz önünde bulundurarak YouTube’a video yüklerler. İnsanların bu videolarda oynadıkları tarz genellikle çok özel bir etkiye yöneliktir.. Hooker, “[Veriler] insanlığın tüm nüanslarını ve tüm varoluş şekillerimizi yakalar mı?” diye soruyor.

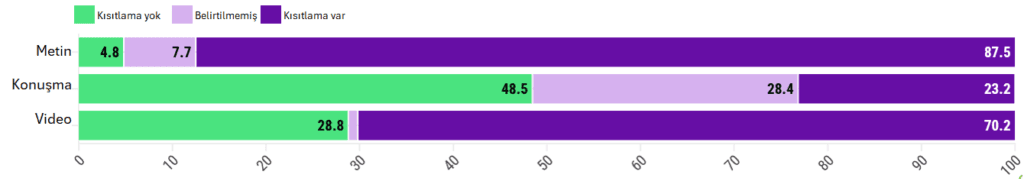

Gizli kısıtlamalar

Yapay zekâ şirketleri genellikle modellerini eğitmek için hangi verileri kullandıklarını paylaşmazlar. Bunun bir nedeni rekabet üstünlüklerini korumaktır. Diğeri ise, veri kümeleri karmaşık ve şeffaf olmayan bir şekilde derlendikleri, paketlendikleri ve dağıtıldıkları için, büyük ihtimalle kendileri bile tüm verilerin nereden geldiğini bilmiyorlar.

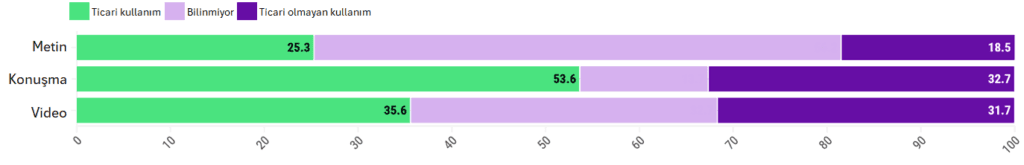

Ayrıca, muhtemelen bu verilerin nasıl kullanılması veya paylaşılması gerektiği konusundaki kısıtlamalar hakkında tam bir bilgiye de sahip değiller. Veri Kökeni Girişimi’ndeki araştırmacılar, veri kümelerinin genellikle kendilerine bağlı kısıtlayıcı lisanslara veya koşullara sahip olduğunu ve bunların örneğin ticari amaçlarla kullanımlarının sınırlanması gerektiğini buldular.

Burada metin, konuşma ve video veri kümelerinin sırasıyla %25, %33 ve %32’sinin ticari olmayan lisanslara sahip olduğunu görebiliyoruz; bu da akademik veya yaratıcı amaçlarla kullanılabilecekleri, ancak para kazanmak için kullanılamayacakları anlamına geliyor.

Birçok veri seti, kaynaklarından birinde gizli kısıtlamalar da taşımaktadır. Veri kümelerinin %78’inden fazlasının kendisinde ya da kaynaklarında ticari olmayan kısıtlamalar bulunmaktadır.

Kaynak: Veri Kökeni Girişimi, Etkileşimli grafik: https://flo.uri.sh/story/2779298/embed

Hooker, “Veri kökenine ilişkin tutarlılık eksikliği, geliştiricilerin hangi verilerin kullanılacağı konusunda doğru seçimi yapmalarını çok zorlaştırıyor” diyor.

Ayrıca, modelinizi telif hakkıyla korunan verilerle eğitmediğinizden tamamen emin olmanızı neredeyse imkansız hale getiriyor, diye ekliyor Longpre.

Daha yakın zamanlarda, OpenAI ve Google gibi şirketler yayıncılarla, Reddit gibi büyük forumlarla ve web’deki sosyal medya platformları ile özel veri paylaşımı anlaşmaları yaptı. Ancak bu, güçlerini yoğunlaştırmaları için başka bir yol haline geliyor.

Longpre, “Bu özel sözleşmeler, İnterneti kimin erişip kimin erişemeyeceğinin belirlendiği çeşitli bölgelere ayırabilir” diyor.

Bu eğilim, bu tür anlaşmaları karşılayabilecek en büyük yapay zekâ oyuncularına, buna erişmek için mücadele edecek araştırmacılar, kâr amacı gütmeyen kuruluşlar ve daha küçük şirketlerin zararına fayda sağlıyor. Üstelik en büyük şirketler veri kümelerini taramak için en iyi kaynaklara da sahipler.

Longpre, “Bu, açık webde daha önce bu ölçüde hiç görmediğimiz yeni bir asimetrik erişim dalgası” diyor.

Batıya karşı diğerleri

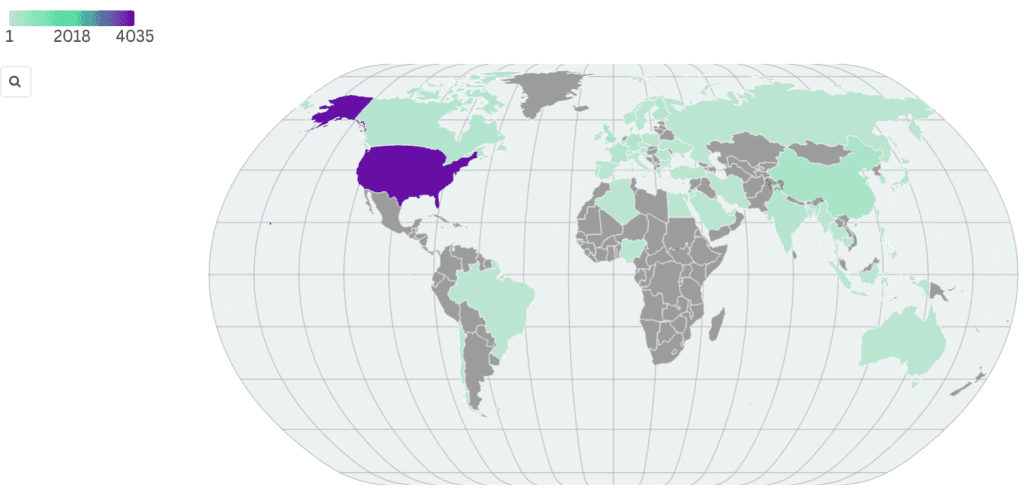

YZ modellerini eğitmek için kullanılan veriler de büyük ölçüde Batı dünyasına doğru meyillidir. Araştırmacıların analiz ettiği veri kümelerinin %90’ından fazlası Avrupa ve Kuzey Amerika’dan, %4’ünden daha azı Afrika’dan geliyor.

Hooker, “Bu veri kümeleri dünyamızın ve kültürümüzün sadece bir bölümünü yansıtıyor, diğerlerini tamamen ihmal ediyor” diyor.

Kaynak ülkeye göre veri kümeleri: Araştırmacıların analiz ettiği veri setlerinin %90’ından fazlası Avrupa ve Kuzey Amerika’dan, %4’ünden azı ise Afrika’dan gelmiştir

Veri: World Bank Official Boundaries, Etkileşimli grafik: https://flo.uri.sh/visualisation/20688990/embed

İngilizce’nin eğitim verilerindeki hakimiyeti, kısmen İnternetin %90’ın üzerinde İngilizce olması ve Dünya’da gerçekten hala İnternet bağlantısının zayıf veya hiç olmadığı pek çok yer olması gerçeğiyle açıklanmaktadır, diyor araştırma ekibinin bir üyesi olmayan ama Hugging Face’nin baş etikçisi olan Giada Pistilli. Ancak bir başka nedenin de kolaylık olduğunu ekliyor: Veri kümelerini başka dillerde bir araya getirmek ve diğer kültürleri hesaba katmak bilinçli bir niyet ve yoğun bir çalışma gerektiriyor.

Bu veri kümelerindeki Batı odağı, çok kipli modellerle özellikle açığa çıkıyor. Örneğin, bir düğünün manzaraları ve sesleri için bir yapay zekâ modeli istendiğinde, yalnızca Batı düğünlerini temsil edebilir, çünkü eğitildiği tek şey bu, diyor Hooker.

Bu, önyargıları pekiştirir ve ABD merkezli belirli bir dünya görüşünü dayatan, diğer dilleri ve kültürleri silen yapay zekâ modellerine yol açabilir.

Hooker, “Bu modelleri tüm dünyada kullanıyoruz ve gördüğümüz dünya ile bu modellere görünmez olan şey arasında büyük bir tutarsızlık var” diyor.

Kaynak: MIT Technology Review, 18 Aralık 2024

- Resim: Stephanie Arnett/MIT Technology Review | Adobe Stock ↩︎

- çn. Data Provenance Initiative ↩︎

- çn. dönüştürücü (transformer), Google’daki araştırmacılar tarafından geliştirilen ve 2017 tarihli “Attention Is All You Need” makalesinde önerilen çok başlı dikkat mekanizmasına dayanan bir derin öğrenme mimarisidir. ↩︎

- çn. gerçek dünyadan toplanmamış, gerçek dünya verilerini taklit eden, insan tarafından oluşturulmamış, bilgisayar simülasyon ve algoritmalarıyla oluşturulmuş verilerdir. ↩︎